-

互联网不断涌现出新的信息,新的设计模式和大量的数据。将这些数据组织到一个独特的库中并非易事。不过,有大量优秀的网页抓取工具可供使用。

ProxyCrawl

使用Proxy Crawl API,你可以抓取Web上的任何网站/平台。有代理支持,绕过验证码,以及基于动态内容抓取JavaScript页面的优势。

它可以免费获得1000个请求,这足以探索Proxy Crawl在复杂的内容页面中所采用的强大功能。

Scrapy

Scrapy是一个开源项目,为抓取网页提供支持。Scrapy抓取框架在从网站和网页中提取数据方面做得非常出色。

最重要的是,Scrapy可用于挖掘数据,监控数据模式以及为大型任务执行自动化测试。强大的功能可与ProxyCrawl完美集成。使用Scrapy,由于内置工具,选择内容源(HTML和XML)是一件轻而易举的事。也可以使用Scrapy API扩展所提供的功能。

Grab

Grab是一个基于Python的框架,用于创建自定义Web Scraping规则集。使用Grab,可以为小型个人项目创建抓取机制,还可以构建可以同时扩展到数百万个页面的大型动态抓取任务。

内置API提供了执行网络请求的方法,也可以处理已删除的内容。Grab提供的另一个API称为Spider。使用Spider API,可以使用自定义类创建异步搜寻器。

Ferret

Ferret是一个相当新的网页抓取,在开源社区中获得了相当大的吸引力。Ferret的目标是提供更简洁的客户端抓取解决方案。例如,允许开发人员编写不必依赖于应用程序状态的抓取程序。

此外,Ferret使用自定义的Declarative语言,避免了用于构建系统的复杂性。相反,也可以编写严格的规则来从任何站点抓取数据。

X-Ray

由于X-Ray,Osmosis等库的可用性,使用Node.js抓取网页非常简单。

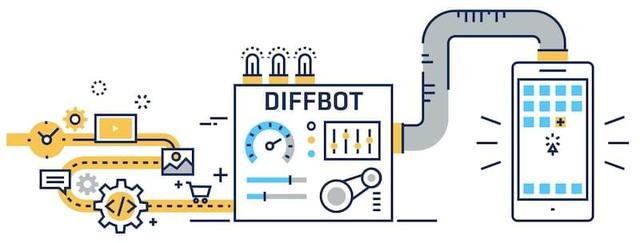

Diffbot

Diffbot是市场上的新玩家。你甚至不必编写太多代码,因为Diffbot的AI算法可以从网站页面解密结构化数据,而无需手动规范。

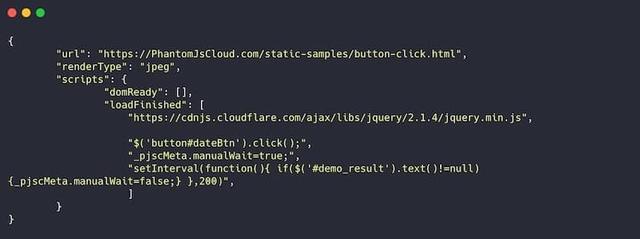

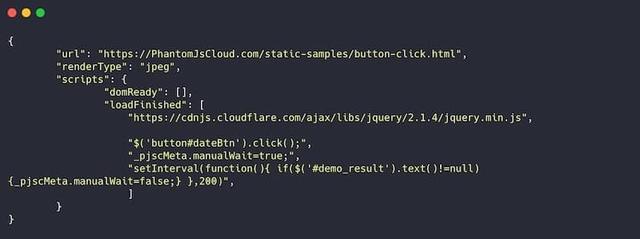

PhantomJS Cloud

PhantomJS Cloud是PhantomJS浏览器的SaaS替代品。使用PhantomJS Cloud,可以直接从网页内部获取数据,还可以生成可视文件,并在PDF文档中呈现页面。

PhantomJS本身就是一个浏览器,这意味着你可以像浏览器一样加载和执行页面资源。如果你手头的任务需要抓取许多基于JavaScript的网站,这将特别有用。

来源:松松科技 QQ/微信:lusongsong7

推荐七款2018年最佳网页抓取工具

|

相关文章阅读更多:职场 软件 程序员

- 2015-04-04 清明祭奠:怀旧那些经典的老软件、老网站

- 2015-06-02 “狗语”翻译软件问世:正确率超80%

- 2015-06-15 一盒面膜转手4次 从85元涨到218元

- 2015-06-22 换个角度看地球:直播地球的网站

- 2016-12-23 免费办公软件LibreOffice 5.2.4发布下载

- 2017-02-20 有哪些神奇的软件

- 2017-03-27 全球安装量最高的PC软件排行帮,你用了几款?

- 2017-04-14 干货,收藏级别的电影资源网站!

- 2017-05-17 自媒体大咖每天都要打开的工具网站,快收藏吧!

- 2017-05-19 等了两年,谷歌小程序终于接入安卓、微软

- 2017-08-09 QQ旋风死亡:国内下载软件衰落的真正原因

- 2017-08-10 BAT旗下的这几个良心网站,非常实用

- 2017-08-14 IT行业最赚钱的岗位是它,妹纸找IT男做老公的先看看

- 2017-10-04 苹果向8位高管发股票:每人拿了合1亿多人民币

- 2020-06-28本站开通了在线投稿,点此立刻给我投稿哦!

发表感想加入微信群

点此登录松松云平台免费认证